PHP 程序员如何为 AI 浏览器(如 ChatGPT Atlas)优化网站

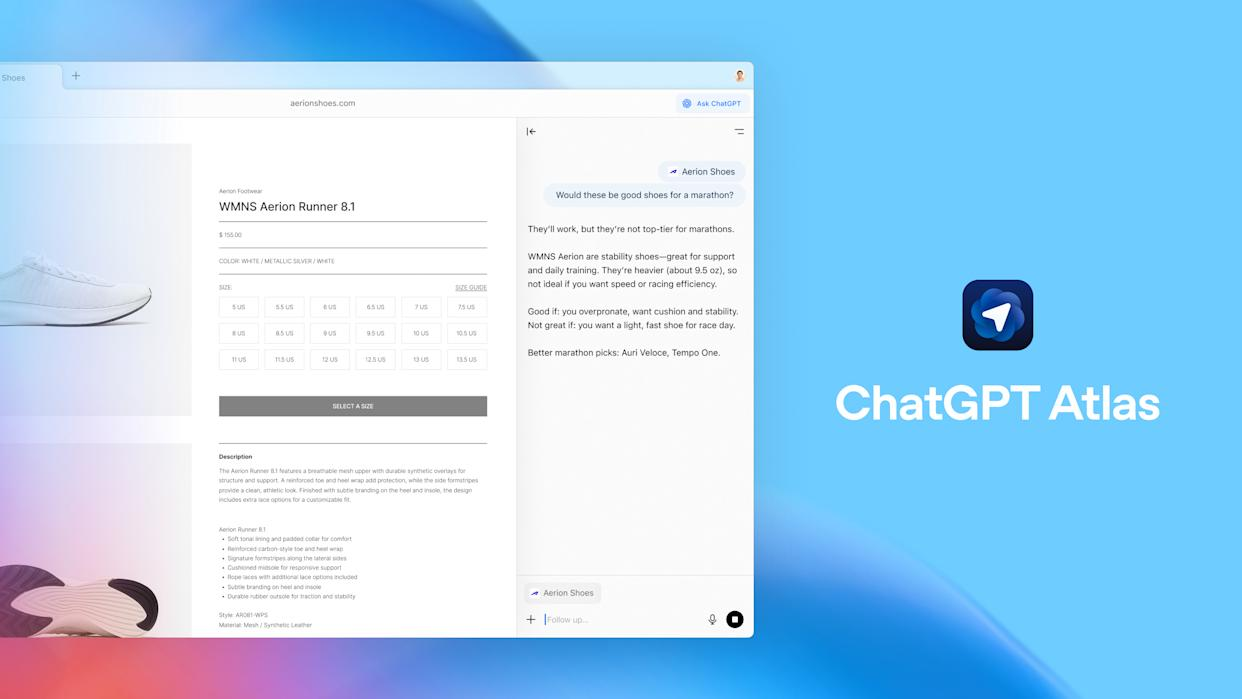

OpenAI 最近推出的 AI 浏览器 ChatGPT Atlas,我个人认为:ChatGPT Atlas 是一个 有力的方向尝试,但还不是“立刻颠覆现有浏览器格局”的确定性事件。

它的愿景很吸引:浏览器 + AI 助手 = 更高效的上网体验。

但在普及、用户习惯建立、生态建设(扩展至 Windows/移动)、内容适配/安全规范完善等方面还有不少工作。

对开发者而言,这是 一个提前准备的大好时机。如果你能率先让自己的网站适应这类新浏览/AI访问模型,就可能比别人多获得“AI推荐”“浏览器内被引用”的机会。

对于建站的PHPer来说有哪些是值得要注意的呢?

- 传统 SEO 注重关键词、链接、用户行为等;但 AI/聊天机器人更多依赖 可读性、结构化、语义理解、机器可调用性。(A/B Testing Software)

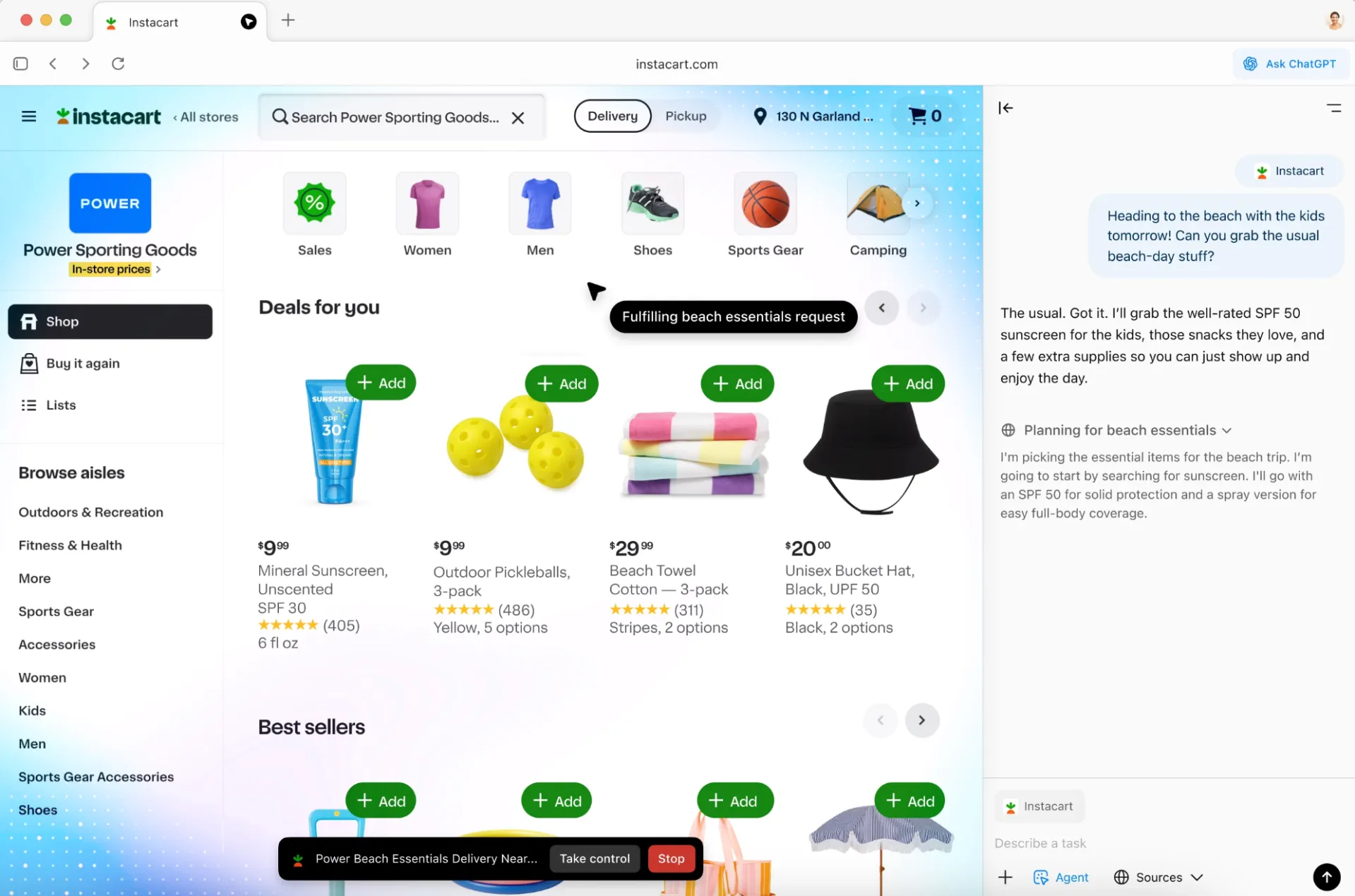

- 如果你的网站被 AI 工具在回答用户查询时 摘录、引用或作为来源,即便用户不点入你的网站,也有品牌/认知/流量/转化机会。(Marketing Aid)

- AI 爬虫(或称 “agent 浏览模式”)可能具有不同的抓取逻辑:比如它可能不会执行大量客户端 JS,或者只抓取一部分内容。若你的网站只有繁重客户端渲染,就可能“瞎抓不到”内容。(Interrupt Media)

因此,作为 PHP 程序员/网站开发者,建议你从以下几个维度入手:技术结构、内容优化、数据可调用性、安全 & 授权三方面。

AI 工具在抓取你的网站内容时,与传统搜索引擎抓取类似,但也有特殊要求。以下是你在 PHP 网站中应重点关注的技术项:

检查

robots.txt,确认没有误阻 AI 爬虫。很多文章提到:如果Disallow: /或忽略 AI 爬虫 user-agent,会导致内容被忽视。(Search Engine Land)若你的防火墙、WAF、CDN 有“阻止爬虫/机器人访问”的设置,建议识别并 允许可信的 AI 爬虫/agent。(Avenue Z)

例如:在

robots.txt中加入类似:User-agent: ChatGPT-User Allow: /但注意:目前没有统一标准,所以你可能需要查看目标平台(如 OpenAI、Microsoft、Anthropic)的抓虫标识。(Prerender)

- 如果网页的大量内容通过前端 JS 动态生成(Client Side Rendering, CSR),AI 爬虫可能无法完整执行或延迟抓取。推荐使用服务器端渲染(SSR)或静态生成(SSG)。(zeo.org)

- 在 PHP 世界里,这意味着:用 PHP 输出完整 HTML,而不是先输出空 HTML 再由 JS 填充。也可以用缓存 +预渲染技术。参考文章:“PHP Web 应用中的 SSR 技术” (purelogics.com)

- 示例:使用 Twig/Blade 模板引擎,在服务器端生成完整页面,再输出给客户端。这样 AI 爬虫收到的是完整可抓取内容。

- AI 爬虫可能设置超时/抓取深度限制,页面加载太慢或阻塞太多资源,会降低被抓取的概率。建议优化页面加载性能(图片压缩、减少阻塞 JS/CSS、启用缓存、CDN)。(Xponent21)

- 确保页面结构语义清晰(H1–H6、

<article>、<section>),HTML 语义标记正确,有利于机器理解。(agilitycms.com)

AI 工具喜欢结构化标记,因为它们更容易理解内容语义。建议在关键页面中插入 JSON-LD 或 microdata,比如

@type: Article、FAQPage、HowTo。(Xponent21)在 PHP 模板中,输出类似:

<script type="application/ld+json">{ "@context": "https://schema.org", "@type": "Article", "headline": "你的标题", "description": "简要描述", "datePublished": "2025-10-22", "author": { "@type": "Person", "name": "作者名字" }}</script>这样让 AI 更容易识别你页面是文章、FAQ、教程等。

- 随着 agent 化浏览器的兴起,文章提到的网站优化方式包括:提供

llms.txt(类似 robots.txt,但为 LLM 提供提示)或公开 OpenAPI/Plug-in manifest 以让 AI agent 调用你的网站数据。(TECHCOMMUNITY.MICROSOFT.COM) - 如果你的网站有 API(例如产品查询、库存、文章检索等),可以考虑暴露一个规范的 OpenAPI JSON 文件,或者在

.wellknown/ai-plugin.json中提供元数据。这样,未来 AI agent 可直接调用你的服务。 - 虽然这是进阶但值得考虑,特别是你是电商、SaaS、工具类网站。

技术结构做好只是基础,内容本身也必须满足 AI 的“推荐逻辑”。以下是你在内容创作、排版、语义上的优化建议。

- AI 检索/引用时更倾向于有权威、有深度、有原创价值的内容,而不是浅薄重复。(forgeandsmith.com)

- 例如:解释为什么、如何做,不只是列步骤;提供背景、数据、案例。这样更容易成为 AI 引用来源。

写作时站在用户提问的角度:他们可能问“如何为 AI 浏览器优化网站?”而不只是“网站优化技巧”。

使用问题型标题/段落(FAQ 样式)更有助被 AI 抓取。(agilitycms.com)

举例:

<h2>什么是 AI 浏览器?</h2><p>AI 浏览器(如 ChatGPT Atlas 模式)能够 …</p><h2>PHP 程序员如何优化网站以被 AI 抓取?</h2><p>有几个关键步骤:1. … 2. …</p>

- 使用 H1、H2、H3 分层标题;段落短、句子明了。AI 更容易快速抓取并理解结构。(A/B Testing Software)

- 如果文章较长,建议加入目录(TOC)或首段快速总结,使 AI “快速读懂”重点。

- 插入合适图片、图表、视频,可以提高页面内容的丰富度,从而提升在 AI 推荐结果中的机会。(Marketing Aid)

- 但同时确保这些媒体可被访问(alt 属性、caption、可抓取格式)。

- AI 更青睐“新鲜、可靠”的数据。文章信息若过时,可能被忽视。建议定期检查并更新。(A/B Testing Software)

- 虽然 AI 与传统搜索不同,但建立“主题集群”(Topic Cluster)仍有助于内容被理解为一个整体、权威的资源。可在文章间通过内部链接连接。(Xponent21)

- 虽然“希望被抓取”是优化目标,但也有网站出于版权或商业考虑,选择阻止某些 AI 爬虫。你需要明确自己的意向。文章提到:一些网站通过 robots.txt 或 Cloudflare 等工具阻止 AI 爬虫访问。(The Verge)

- 如果你愿意让 AI 抓取,就明确允许;如果不愿意,就在 robots.txt 或通过版权声明、接口限制等方式管理。

- 目前 AI 引荐/引用带来的流量可能不会像传统点击那样易于追踪。建议:在网站中加入“你是从哪来的?”类型问卷、在表单中设置“如何得知我们?”字段。(A/B Testing Software)

- 检查服务器日志,看看是否有 AI 爬虫的访问痕迹(User-Agent、IP 段、访问频率)。(Reddit)

- 虽说你希望被抓取,但不要将服务器暴露给恶意抓取/高频爬虫导致资源被滥用。合理设定爬虫访问频率、CDN 限流、防火墙白名单。(Electronic Frontier Foundation)

- 保证敏感数据不被公开:AI 爬虫也可能将你页面内容作为训练数据的一部分。确保不要泄露内部资料、用户隐私、未授权 API。

下面是一个对 PHP 开发者而言、按步骤可执行的优化清单,建议一项一项落实:

检查

robots.txt文件:- 确认是否有误禁止主站点或重要页面。

- 如愿意让 AI 抓取,可加入允许 AI 爬虫 User-Agent 的条目。

确保关键页面通过 SSR 输出标准 HTML:

- 如果你使用框架(如 Laravel、Symfony、WordPress 自定义主题),确保内容不是纯客户 JS 渲染。

- 如果有单页应用(SPA)部分,考虑为这些页面提供静态预渲染或服务器端预渲染版本。

优化页面速度:

- 启用 PHP-opcache、加速模块。(维基百科)

- 使用缓存机制(页面缓存、片段缓存、对象缓存)。

- 图片压缩、启用延迟加载(lazy-load)、减少初始 JS/CSS 阻塞。

在模板中加入结构化数据(Schema):

- 根据页面类型(文章、产品、FAQ、事件)输出对应 JSON-LD。

- 确保 metadata(title, description)正确、简洁且符合内容。

内容创作方面:

- 开始文章前,定义用户可能提问的问题(如 FAQ)。

- 使用 H1/H2/H3 清晰分层,首段直接说明核心观点(“TL;DR”)。

- 加入图片/图表辅助说明。

- 在适当位置加入内部链接,建立内容集群。

考虑未来扩展(如 agent 可调用):

- 如果你的网站提供 API,可考虑编写 OpenAPI 规范,并公开

.well-known/ai-plugin.json或类似元数据。 - 在根目录考虑放置

llms.txt,简单说明你网站的重要内容或 FAQ,便于 AI 快速 “摘要” 你的站点。(TECHCOMMUNITY.MICROSOFT.COM)

- 如果你的网站提供 API,可考虑编写 OpenAPI 规范,并公开

监控 +日志分析:

- 检查访问日志是否有未知爬虫频繁访问。

- 在重要落地页表单或者交互中加入来源字段(如“通过哪款 AI 工具得知我们?”)。

- 定期查看页面加载时间、抓取频率、页面错误。

作为 PHP 程序员,为 AI 浏览器优化你的网站,其实是在做好两件事:

- 让机器/爬虫“看懂”你的网站结构、内容:通过 SSR、结构化数据、语义明确、抓取权限允许。

- 做好内容本身的“被引用价值”:高质量、有深度、易理解、用户问答结构强。

如果你能同时在技术和内容两端下功夫,你的网站就有更大机会在 AI 驱动的浏览/搜索/代理环境里被引用,从而带来品牌影响、流量转化、未来机会。

- 本文分类:AI

- 本文标签:PHPAI提示词

- 浏览次数:480 次浏览

- 发布日期:2025-10-22 20:54:50

- 本文链接:https://zmzhz.com/ai/148.html

发表评论 取消回复